SPIS TREŚCI:

W polu zainteresowań każdego przedsiębiorcy działającego online zawsze leży SEO dla jego strony internetowej. Niezależnie od tego czy mówimy o managerze marketingu z dużego banku, czy o hydrauliku z Radomia – każdy chce wiedzieć, ile trzeba czekać na efekty pozycjonowania. Dla każdego z nich równie istotne będzie to, ile kosztuje SEO.

Niestety nie da się na te pytania przygotować jednej, uniwersalnej odpowiedzi. Wyniki pozycjonowania zależą od setek czynników, więc podobnie sprawa się ma do odpowiedzi na pytania o długość i koszty SEO. W poniższym artykule odpowiemy na pytania, ile czasu zajmuje pozycjonowanie strony, ile kosztuje oraz co ma na to wpływ.

Co to jest pozycjonowanie strony internetowej?

Tytułem wstępu określmy w ogóle, czym jest pozycjonowanie (SEO – Search Engine Optimization). Otóż to zestaw działań podejmowanych w celu poprawienia pozycji strony internetowej w wyszukiwarkach na konkretne frazy kluczowe. Obejmuje to wyniki organiczne, czyli wyświetlające się poniżej wyników oznaczonych w wyszukiwarce jako reklamy. Ten skomplikowany proces wymaga dużej wiedzy, doświadczenia i zaangażowania aby był skuteczny i przynosił wymierne efekty.

Jak długo trwa pozycjonowanie strony?

Jak wyżej nadmieniłem, wpływ na to mogą mieć setki czynników. Jednak są takie, które będą ważniejsze od innych i to na nie powinniśmy zwrócić szczególną uwagę starając się odpowiedzieć sobie na to pytanie. Możemy przyjąć, że minimalny czas pozycjonowania to ok. 1 miesiąc. To rzadkie przypadki, gdzie dobry audyt SEO i optymalizacja strony znacznie poprawiają widoczność i już po takim czasie możemy obserwować wzrost pozycji w wyszukiwarce. Każda strona oraz każda kampania SEO są jednak różne i należy rozpatrzyć zdecydowanie więcej czynników. Zazwyczaj czas oczekiwania na pierwsze efekty pozycjonowania wynosi kilka miesięcy od rozpoczęcia współpracy. Musimy pamiętać jednak, że SEO to praca ciągła, która powinna trwać nieprzerwanie. Zatrzymanie prac co prawda nie skutkuje nagłym spadkiem ruchu do zera, jak w przypadku kampanii płatnych co jest jedną z najważniejszych zalet SEO. Jednak od zatrzymania działań zaobserwujemy spadający ruch i konwersje, a powrót do poziomu ruchu sprzed spadków będzie czasochłonny.

Co ma wpływ na czas pozycjonowania strony?

Poniżej lista kluczowych elementów, na które powinniście zwrócić szczególną uwagę. Zatem, od czego zależy pozycjonowanie w Google i jak te czynniki wpływają na czas i koszt pozycjonowania strony?

Konkurencyjność branży

SEO możemy porównać do wyścigu – pozycjonowanie będzie tak trudne jak silna będzie nasza konkurencja. Jeżeli nie mamy konkurencji na rynku to czas na wyniki oraz budżet, jaki musimy wydać, będzie znacznie niższy niż w wypadku, gdy musimy rywalizować z innymi stronami. Podobnie jak w wyścigu, nie sztuką jest zająć 5 miejsce kiedy mamy 4 konkurentów, ale jeśli jest ich 20, to możemy mówić o sukcesie.

Ma to związek między innymi z tym jakie zwroty z inwestycji możecie uzyskać. Inną kwotę zarobi hydraulik za 1 zlecenie, a inną portal udzielający pożyczek online. Im potencjalne korzyści są większe, tym większe mamy prawdopodobieństwo, że inwestycje w SEO były na wysokim poziomie, ponieważ wysokie pozycje przynosiły wysokie zyski, a konkurencja była większa.

Dla określenia potencjalnych kosztów i czasu pozycjonowania strony www możliwie precyzyjnie, działania SEO powinna poprzedzać skrupulatna analiza konkurencji. Dzięki niej możemy przygotować wyceny pozycjonowania oraz estymacje rezultatów w czasie, które są oparte na danych. Tak ułożony proces pozycjonowania pozwala możliwie bezpiecznie alokować budżet SEO i przewidywać wyniki w czasie ze stosunkowo dużą precyzją.

Wspomniani wcześniej hydraulik i manager marketingu dostaną zupełnie inne odpowiedzi na pytanie, ile potrwa pozycjonowanie już na podstawie tego jednego czynnika.

Widoczność strony internetowej

Kolejnym elementem, który ma kluczowy wpływ na, to ile kosztuje pozycjonowanie stron, jest punkt startowy dla działań. Jeżeli strona, nad jaką zaczynamy pracę nie będzie posiadała historycznej widoczności na frazy kluczowe powiązane z tematem jaki chcemy pozycjonować to będzie trudniej zwiększyć jej pozycje w porównaniu do strony, która taką widoczność miała. Google bierze pod uwagę wypracowany autorytet domeny i historyczną widoczność w procesie ustalania pozycji strony, więc jeżeli będzie miało do wyboru stronę internetową, która w przeszłości była związana z daną frazą czy tematyką, to będzie ona miała przewagę w dalszych działaniach SEO.

Stosunkowo wysoka widoczność to także połowa sukcesu dla konkretnych fraz kluczowych. Jeżeli celujemy na daną frazę w TOP10, czy nawet TOP3 to start z pozycji 15, czy 20 będzie zdecydowanie lepszy niż rozpoczęcie działań bez pozycji. W takiej sytuacji wiemy, że Google już zna naszą stronę, wiąże ją z danym hasłem i tematyką i zazwyczaj wystarczy kilka poprawek do podciągnięcia wyników. Pozycja jest wypracowana dla konkretnej podstrony, na której możemy zoptymalizować i rozbudować treści lub pozyskać do niej dodatkowe linki. Możemy także optymalizować całą witrynę pod kątem technicznym, co także będzie miało wpływ na tę konkretną podstronę. Możemy rozbudować linkowanie wewnętrzne do niej itd. itp. Mamy szeroki zakres działań, które możemy wykonać i stosunkowo szybko obserwować ich rezultaty. W przypadku, kiedy historycznych pozycji brakuje, musimy wypracować „zaufanie” algorytmów od zera co trwa zdecydowanie dłużej.

Trzymając się historii hydraulika i managera marketingu – jeżeli nasz hydraulik zacznie pozycjonować swoją stronę postawioną na świeżo zakupionej domenie, to będzie musiał poczekać trochę dłużej niż gdyby kupił domenę parę lat temu i trzymał na niej swoją stronę firmową, nawet bez większej optymalizacji.

Dobór słów kluczowych

Wysokie miejsce w rankingu czynników decydujących o wynikach wyszukiwania zajmują słowa kluczowe, które chcemy wypozycjonować.

Dobór fraz kluczowych do działań to jeden z czynników, który będzie niemalże decydujący o czasie i cenie pozycjonowania. Wysoce konkurencyjne frazy będą wydłużały proces pozycjonowania strony, ale jednocześnie z dużym prawdopodobieństwem będą przynosiły wyższe zwroty z inwestycji po osiągnięciu wysokich pozycji.

Podkreślę tutaj, że dobór fraz kluczowych pod kątem SEO może być zróżnicowany na poziomie trudności nie tylko pomiędzy branżami, ale także w ramach jednej branży, a nawet poszczególnych produktów i usług. Inny stopień trudności dla agencji SEO będzie stanowiła fraza kluczowa „chwilówki przez internet”, a inny „dobry fryzjer w Radomiu”. Sami, bez doświadczenia SEO, zapewne trafnie określicie, która będzie stanowiła większe wyzwanie.

Niezwykle ważną kwestią, którą należy brać pod uwagę w trakcie dobierania słów kluczowych, jest identyfikacja intencji wyszukiwania. Na bazie frazy kluczowej oraz wyników organicznych, jakie się pod nią pojawiają, możemy określić czy użytkownik z większym prawdopodobieństwem szuka możliwości zakupu, poszerzenia wiedzy o produkcie, czy może rozwiązania swojego problemu. Inną podstronę przygotujemy dla frazy „jak naprawić zepsuty zlew” inną dla frazy „naprawa zepsutego zlewu” a jeszcze inną dla „zlew 50×50”.

Odpowiedni dobór fraz oraz analiza słów kluczowych to jedno z najważniejszych wyzwań, jakie stają przed agencją SEO. Ten etap będzie krytyczny dla skuteczności pozycjonowania strony. Jeżeli frazy nie zostaną dobrane prawidłowo (np. dla hydraulika zostaną zaplanowane frazy charakterystyczne dla ecommerce) to szanse na sukces są bardzo małe i nie mówimy wtedy o czasie, jaki będzie trwało pozycjonowanie, ale raczej o tym, czy w ogóle uda się cokolwiek wypozycjonować. Google chce wyświetlać użytkownikom jak najbardziej trafne strony i powinniśmy o tym pamiętać w trakcie dobierania haseł do działań i późniejszej optymalizacji strony.

Nasz hydraulik może odetchnąć. Mimo że nie ma domeny z historią to jednak słowa kluczowe, które będą go interesować, nie będą należały do najtrudniejszych. Dodatkowo zakres jego działalności jest ograniczony, co prowadzi nas do kolejnego czynnika.

Zasięg działalności

W skrócie: pozycjonowanie lokalne będzie łatwiejsze niż to o zasięgu krajowym lub międzynarodowym.

Jest to związane bezpośrednio z czynnikiem, jaki omówiłem wcześniej – konkurencyjnością branży. Lokalne biznesy posiadają zdecydowanie mniej konkurentów niż te ogólnokrajowe lub nawet międzynarodowe. Mniejsze będą także zwroty z inwestycji marketingowych w takich działalnościach, więc nikt nie przeinwestuje swojego SEO odstawiając konkurencję o kilka długości, bo takie działanie zwyczajnie nie zwróci się w sensownym czasie. Do zwiększenia widoczności witryny lokalnej będzie nam potrzebne więc zazwyczaj mniej czasu niż w przypadku działalności wykraczającej poza nasz region.

Kolejna dobra informacja dla naszego hydraulika.

Budżet pozycjonowania

Budżet na działania SEO jest zależny od efektów, jakie chcemy uzyskać, a efekty od budżetu, jaki mamy. W określaniu celu dla współpracy zawsze z naszymi Klientami staramy się wychodzić od jednego lub drugiego, wtedy możemy realnie wycenić lub estymować usługę pozycjonowania.

W określonym budżecie możemy pozyskać tylko ograniczoną liczbę wartościowych linków, wysokiej jakości treści lub wartościowych wytycznych SEO. I tak jak w większości branż im więcej kosztować nas będą poszczególne elementy, tym będą zazwyczaj lepsze, co w przypadku SEO przekłada się na krótszy czas i koszt pozycjonowania strony. Większy budżet na pozycjonowanie pozwoli zlecić treści ekspertom z danych dziedzin, pozyskać linki z mocniejszych portali i zaangażować do projektu większą ilość specjalistów na więcej godzin.

Warto w tym wypadku przyjrzeć się podziałowi budżetu ze względu na to, że każda agencja może podchodzić do tego inaczej. W jednej dostaniecie za 5000 zł pracę, treści i linki warte tej ceny pozycjonowania, w innej z tej kwoty 4000 zł będzie stanowiło marżę agencji SEO. Nie bójcie się pytać, co składa się na budżet z oferty, bo od tego będzie zależała skuteczność działań dla Was prowadzonych.

Weryfikacja tego na ile jakościowe i warte swej ceny działania proponuje agencja SEO, może stanowić jednak dla przedsiębiorców wyzwanie. I o ile trudno coś w tym zakresie zmienić jeżeli chodzi o samą merytorykę to jest jednak kilka elementów, na jakie warto zwrócić uwagę. Agencje, które oferują jakościowe usługi pozycjonowania zazwyczaj:

- Transparentnie wskazują, na co i w jakich proporcjach przeznaczony jest budżet;

- Potrafią i chcą wyjaśnić z czego wynika przyjęte podejście do działań i zakresu prac;

- Oferują jasne raportowanie wykonanych prac i efektów;

- Zapewniają kontakt ze specjalistą SEO prowadzącym projekt;

- Oferują uczciwe dla obu stron umowy na partnerskich zasadach.

To oczywiście tylko kilka ogólnych punktów, ale ich weryfikacja może pomóc wam uchronić się przed agencją SEO, która niekoniecznie zapewni najwyższą jakość i efekty na lata.

Nasz hydraulik mógłby mieć obawy, że jego budżet na pozycjonowanie nie będzie wystarczający. Kompilując ten czynnik z poprzednimi, możemy jednak dojść do wniosku, że czas na wypozycjonowanie strony będzie zależał od radykalnie różnych budżetów w przypadku hydraulika i banku i nawet kilkaset złotych może wystarczyć na efekty, które przyniosą kilku Klientów miesięcznie.

Jakość audytu SEO i analiz początkowych

Zazwyczaj szybciej pojedziesz Mercedesem niż poczciwym maluchem. Nie inaczej jest z SEO. Dobra jakość strony pod kątem prowadzenia działań pozycjonowania jest absolutnie kluczowa do skalowania i skuteczności w czasie.

Przeprowadzenie, i co nawet ważniejsze, wdrożenie audytu SEO jest podstawą tego co możemy wypracować w przyszłości. W ramach audytu badamy stronę pod kątem wszelkich elementów, które możemy poprawić by pozyskiwać więcej wartościowego ruchu. Eliminujemy obecne błędy oraz wskazujemy, w którym kierunku możemy rozwijać stronę aby była jeszcze bardziej przyjazna użytkownikom i algorytmom.

Zakres analiz powinien być kompleksowy i dobierany indywidualnie. Każda strona będzie nieco inna. W zależności od CMSa, wykorzystanych technologii i rozwiązań specjalista SEO musi spojrzeć na stronę w nieco inny sposób oraz rozpatrzyć inne problemy. Niezwykle ważne jest tutaj doświadczenie osoby, która będzie wykonywać taki audyt seo. I to nie jest tak, że specjalista bez większego doświadczeniem np. z Magento nie wykona audytu SEO strony www postawionej na tym CMS. Wykona i zapewne dostarczy wartościowy materiał. Jednak w SEO wiele problemów można rozwiązać w więcej niż jeden sposób. Najlepsze rozwiązania znają Ci, którzy już je wdrażali. Tacy specjaliści zazwyczaj mogą zaproponować rozwiązania najłatwiejsze i najszybsze do wdrożenia, najskuteczniejsze oraz niekolidujące w przyszłości z innymi elementami.

Brak audytu na początku współpracy sprawia, że wszelkie pozostałe działania, takie jak wartościowe treści, czy mocne linki dochodzące nie będą wykorzystywane w pełni ich potencjału. Treści nie będą osiągać topowych pozycji, linki nie wzmocnią strony, tak jak byśmy chcieli. To tak jakbyśmy ścigali się wspomnianym Mercedesem, ale na pierwszym biegu. Będziemy jechać bardzo długo lub w ogóle nie dojedziemy do celu.

Jakość i ilość linków prowadzących do domeny

To kolejna kwestia pozwalająca nam precyzyjniej odpowiedzieć na pytanie „jak długo trwa pozycjonowanie strony internetowej?„. Jest to jednak zazwyczaj element bardzo enigmatyczny dla przeciętnego klienta agencji SEO. Określenie tego, czy linki są dla strony bardzo dobre, przeciętne, czy wręcz złe wymaga dużej znajomości czynników na to wpływających, a ta idzie z doświadczeniem specjalisty prowadzącego projekt.

Przedsiębiorcy mogą spróbować samodzielnie określić jakość linków dochodzących, jednak zadziała to raczej w przypadku większych i jakościowych serwisów. Jeżeli kojarzymy skądś stronę, z której został pozyskany link, to prawdopodobnie będzie on przynajmniej dobrej jakości. Dla lepszego zrozumienia strategii link buildingowej warto po prostu zapytać specjalistę SEO jakie parametry brał pod uwagę. Jeżeli wspomni o widoczności na frazy, szacowanym ruchu na stronie oraz tematyce serwisu to prawdopodobnie jesteśmy w dobrych rękach.

Agencja SEO, analizując profil linkowy Twojej strony www, jest w stanie określić jaki dystans dzieli Cię od konkurencji. Znając stawki wydawców i Twój budżet może także spróbować odpowiedzieć na pytanie ile czasu zajmie pozycjonowanie strony.

W tym zakresie czasami tymczasowe zwiększenie budżetu na opublikowanie dobrej jakości linka może znacznie przyspieszyć uzyskanie zadowalających efektów.

To jakie linki prowadzą do Twojej strony, możesz sprawdzić samodzielnie darmowym narzędziem, jakim jest Google Search Console. Znajdziesz tam większość linków, które prowadzą do Twojej strony oraz informacje, jakie podstrony są podlinkowane.

Twoje zaangażowanie

SEO, w przeciwieństwie do wielu innych kanałów online wymaga stosunkowo dużego zaangażowania klienta. Pozycjonowanie stron to gra zespołowa – agencja przygotuje rekomendacje, klient musi je wdrożyć, agencja stworzy treści, klient musi je przeczytać, zatwierdzić i opublikować itd. W przypadku pozycjonowania, bez zrozumienia wagi zaangażowania w projekt, rezultaty mogą znacznie przesunąć się w czasie, lub wręcz może ich nie być. Po co komu audyt strony, który zostanie schowany do szuflady? Po co artykuły sponsorowane i wartościowe linki skoro nie zostały utworzone potrzebne podstrony? Po co wysokiej jakości treści skoro nie mogą zostać opublikowane przez długi proces akceptacji? Przykłady można mnożyć, jednak musimy pamiętać, że nawet najwyższej jakości praca pójdzie na marne jeżeli klient nie dopilnuje swojej części obowiązków. SEO nie jest kanałem bezobsługowym, wymaga dobrej i dynamicznej współpracy po obu stronach lub bardzo dużego zaufania i podziału obowiązków.

Ile kosztuje pozycjonowanie strony?

To pytanie co do precyzji może być porównane do pytania „ile kosztuje samochód?”. A odpowiedź brzmi: to zależy. Żeby ją pogłębić i doprecyzować musimy dopytać o kluczowe elementy wpływające na wycenę. Świadomość tego co na nią wpływa jest kluczowa do tego aby świadomie zdecydować o swoim budżecie i wyborze właściwego partnera do pozycjonowania strony.

Jak już wcześniej zauważyliśmy na pozycjonowanie stron wpływ mają liczne czynniki. Wymieniliśmy jedynie te absolutnie kluczowe z punktu widzenia przedsiębiorcy, ale i tak na ich podstawie możemy wywnioskować, że coś takiego jak sztywno ustalony, uniwersalny cennik pozycjonowania stron internetowych po prostu nie istnieje. Możemy jednak przyjąć pewne założenia co do konkurencji rynkowej, która ma największe przełożenie na finalne koszty SEO.

Jeżeli prowadzisz mały biznes w mieście powiatowym, to Twój koszt pozycjonowanie zapewne będzie relatywnie niski. Kilku, może kilkunastu konkurentów, ograniczona baza Klientów, ograniczony rynek. To wszystko sprawia, że będzie zarówno niewiele stron do wyprzedzenia jak i że nie warto będzie wydawać dużych kwot na SEO, ponieważ szansa na to, że się zwrócą będzie niska. W takiej sytuacji rynek hamuje wyraźnie „sensowność” wydawania pieniędzy na SEO i reklamę w ogóle.

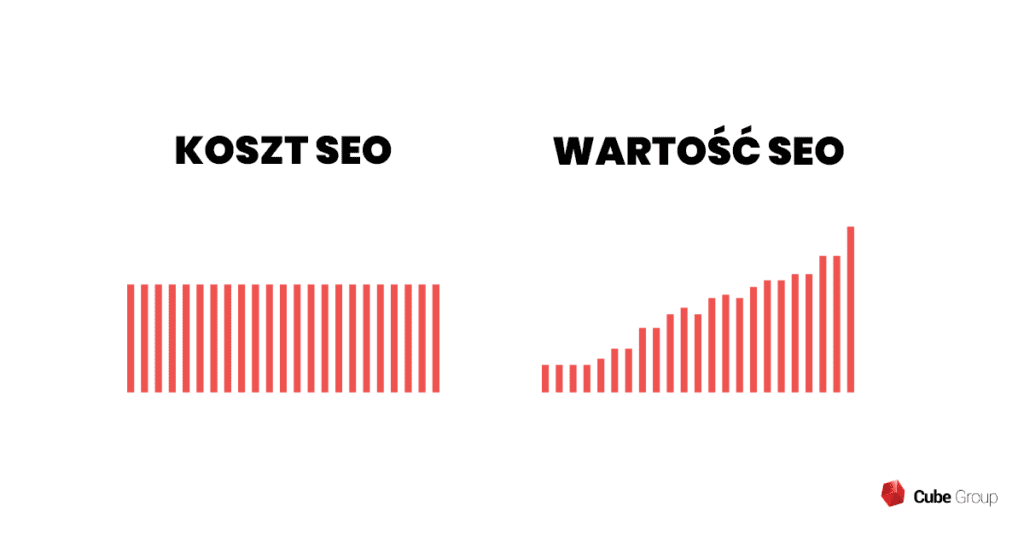

Inaczej sprawa wygląda kiedy mówimy np. o pozycjonowaniu sklepów internetowych. I mówię tutaj raczej o dużych ecommerce, które mają w swojej ofercie tysiące produktów z popularnej branży. W takim wypadku konkurencja, z którą przyjdzie się zmierzyć właścicielowi sklepu to zupełnie inny poziom niż w naszym poprzednim przykładzie. Sklepów z podobnym asortymentem w różnej konfiguracji i działających online może być setki. Każdy z nich będzie chciał wybić się na identyczne frazy kluczowe. Popularne frazy mogą przynosić każdego miesiąca setki sprzedanych koszyków. To sprawia, że zarówno konkurencja będzie wysoka jak i potencjalne zwroty z inwestycji na SEO, czy inne działania marketingowe. W takiej sytuacji cena pozycjonowania, która będzie odpowiednia do osiągnięcia wymiernych celów, będzie relatywnie wyższa. Powyższe przykłady są wyjściem z najbardziej ogólnego punktu widzenia – charakterystyki biznesu Klienta. Jest to najważniejsza rzecz, jaką należy wziąć pod uwagę myśląc o kosztach SEO w kontekście planowania swoich wydatków marketingowych. Warto także pamiętać, że wartość SEO z czasem rośnie. Wydając ten sam budżet każdego miesiąca, będziemy mieć coraz więcej ruchu i konwersji z czasem.

Szacunkowy cennik pozycjonowania stron:

Zakres prac dla każdej strony www jest zawsze ustalany indywidualnie i bez możliwości analizy nie jesteśmy w stanie zasugerować, co powinno się znaleźć w każdym progu cenowym. Dla jednych ważniejszy będzie konsulting i naprawa błędów, dla innych duże ilości dobrych treści, a dla trzecich mocne linki. Znając jednak uwarunkowania rynkowe i posiadając wiedzę i doświadczenie na temat tego jak wyglądają prace SEO w różnych branżach możemy przedstawić rozsądne widełki budżetowe dla Klientów z różnych segmentów rynkowych, które pomogą Ci określić właściwy dla Ciebie budżet na działania SEO.

| Strona oferująca usługi lokalnie | Firma o zasięgu ogólnopolskim (usługi, mały-średni ecommerce, umiarkowanie popularne produkty itp.) | Duża firma o zasięgu ogólnopolskim (popularne usługi, duży ecommerce, popularne produkty itp.) | Wybrane przypadki (duża konkurencja, chęć bardzo szybkich wzrostów, chęć zdominowania rynku itp.) |

| Od 500 zł – 1000 zł do 3000 zł miesięcznie | Od 3000 zł do 15000 zł miesięcznie | Od 10000 zł do 50000 zł miesięcznie | Powyżej 50 000 zł miesięcznie |

| Strony tego typu wymagają zazwyczaj jednorazowej optymalizacji oraz linkowania umiarkowanie mocnymi linkami. Celem zazwyczaj jest osiągnięcie i utrzymanie pozycji na frazach dotyczących usług lokalnych. | Strony wymagają zazwyczaj kompleksowego audytu, tworzenia treści produktowych, pozyskiwania umiarkowanie mocnych linków i rozwoju treści blogowych. Celem jest pozyskiwanie leadów i zakupów w atrybucji last click oraz dostosowanie SEO do ścieżek Klienckich uwzględniających inne kanały. | Strony wymagają zazwyczaj kompleksowych audytów pod różnymi kątami, tworzenia treści produktowych, pozyskiwania mocnych linków i dynamicznego rozwoju treści blogowych. Celem jest pozyskiwanie leadów i zakupów w atrybucji last click oraz dostosowanie SEO do ścieżek Klienckich uwzględniających inne kanały i kreowanie nowych ścieżek. | Projekty tego typu wymagają zazwyczaj maksymalnego nacisku na wszystkie kwestie SEO – najmocniejsze linki, bardzo duże ilości treści produktowych i blogowych, poprawa olbrzymich i skomplikowanych stron pod kątem technicznym co zajmuje często dziesiątki, a nawet setki godzin miesięcznie. |

Czy istnieje tanie pozycjonowanie stron?

Nie, tanie pozycjonowanie stron nie istnieje. Pozycjonowanie stron to skomplikowany proces, na który składają się setki, jak nie tysiące czynników. Specjaliści SEO zdobywają swoje doświadczenie latami aby dobrze wykonywać swoją pracę. Dodatkowo cały proces wymaga stałego ponoszenia kosztów narzędzi, opłacania wydawców i copywriterów. Jeżeli chcemy znaleźć tanie pozycjonowanie, to niestety prawdopodobnie nie będzie szło w parze ze „skutecznym pozycjonowaniem”.

Doprecyzowując odpowiedź. Tanie pozycjonowanie stron istnieje, jednak tanie i skuteczne pozycjonowanie stron – nie.

Aby rozsądnie wydać pieniądze na SEO i content marketing, powinniśmy dobrze wybrać partnera do działań, angażować się w prace, analizować wraz z agencją raporty, pilnować ROI, obserwować punkty styku z innymi kanałami, prowadzić monitoring pozycji, odwiedzać Google Search Console i wiele innych. Żeby uzyskać dobre efekty możemy zainwestować swoje pieniądze i czas. Nie inwestując żadnej z tych rzeczy, prawdopodobnie nie zyskamy nic. Jednak inwestując obie, możemy osiągnąć wspaniałe rezultaty!

Czy samodzielne pozycjonowanie to dobry pomysł?

Samodzielne pozycjonowanie to nie jest dobry pomysł, nawet jeżeli posiadamy podstawową wiedzę na ten temat – jest to proces czasochłonny i wymagający ciągłej edukacji i rozumienia setek zależności. Dobrym pomysłem jest jednak aktywne uczestniczenie w pracach i ścisła współpraca z agencją SEO.

Samodzielnie możemy podjąć się:

- Prób tworzenia nowych treści – jest to dobry pomysł, ponieważ to nasza ekspertyza dotycząca branży, w jakiej funkcjonujemy, będzie stanowiła o ich jakości. Więcej jakościowych treści to zawsze większa szansa na widoczność na dodatkowe frazy. Jednak o sukcesie treści w Google nie stanowi jedynie eksperckie podejście, ale także optymalizacja SEO, linkowanie wewnętrzne, zapobieganie duplikacji i wiele innych elementów, o których nie będziemy wiedzieć bez doświadczenia SEO.

- Samodzielnego pozyskiwania linków – w ramach współpracy barterowej i stricte biznesowych możemy często mieć szansę na zdobycie nowych odnośników bardzo tanio lub zupełnie za darmo. To również świetny pomysł, ale i tutaj problemem może okazać się brak wiedzy. Nie będziemy w stanie dobrze określić jaką moc zapewniają linki, czy nie przepalamy budżetu i czasu i czy w ogóle nasze działania przyniosą efekty. Bez wiedzy SEO może okazać się, że po wielu miesiącach, po dziesiątkach rozmów pozyskamy setki linków, a ich moc będzie znikoma w kontekście naszych potrzeb.

- Optymalizacji technicznej – jednak w tym wypadku bardziej prawdopodobne jest zaszkodzenie sobie niż pomaganie. Istnieje wiele wtyczek i darmowych narzędzi, które mogą pomóc naprowadzić użytkownika na dobrą optymalizację, jednak zawsze funkcjonują one na bazie pewnych wytycznych, które nie przewidzą wszystkich zależności. Optymalizacja jednego parametru może prowadzić do zepsucia innego. Chociaż pewne elementy łatwo poprawić (np. rozmiar grafik) to jednak ten aspekt pozostawiłbym w pełni doświadczonym ekspertom.

Największym problemem samodzielnych działań jest ich niestabilność. Bez wiedzy SEO możliwe jest zdobycie pewnej widoczności za pomocą treści i linków, ale zazwyczaj jest to bez konkretnej wiedzy, co dokładnie wpłynęło na to, że z frazy X pojawił się na stronie ruch. Jedna niekorzystna zmiana algorytmu może zniweczyć naszą pracę i zostaniemy bez efektów i wiedzy jak je odbudować. Nie stworzymy w ten sposób stabilnego filaru naszego biznesu.

Kolejną kwestią jest opłacalność takiego procesu. W pracy SEO wykorzystywane są liczne, zazwyczaj dosyć drogie, narzędzia, których zakup tylko i wyłącznie do naszego projektu może być porównywalny z kosztami zatrudnienia agencji.

Ostatnią kwestią, jaką moim zdaniem powinniśmy przeanalizować, w pierwszej kolejności jest to, czy nasz czas pracy nie przyczyni się bardziej do zwiększenia naszych zysków, kiedy zajmiemy się naszą pracą, a SEO zostawimy ekspertom. Czasami nie warto poświęcać wielu godzin na naukę, tworzenie treści itp. aby zaoszczędzić kilkaset złotych na SEO bo w szerokiej perspektywie nasz czas i kreatywność mogą okazać się znacznie ważniejsze gdzie indziej.