Wyszukiwarka Google w celu wyświetlenia stron najlepiej odpowiadających na zapytania użytkowników korzysta z bardzo skomplikowanego systemu rankingowego. Oparty jest on na wielu specjalnych algorytmach. Jak one działają, czego dotyczą i które są najważniejsze? Tego dowiesz się z artykułu.

SPIS TREŚCI:

- Jak działa wyszukiwarka Google?

- Algorytmy Google – które są najważniejsze?

- PageRank

- Panda

- Pingwin

- Page Layout (Above the fold)

- Koliber (Hummingbird)

- RankBrain

- BERT

- Aktualizacje algorytmu Google

- Mobile friendly update (Mobilegeddon)

- Mobile first indexing

- Medic update (YMYL / EAT update)

- Page experience update (Core Web Vitals)

- Core updates (Google broad core algorithm updates)

- Podsumowanie

Jak działa wyszukiwarka Google

Według różnych źródeł mechanizm wyszukiwarki Google wykorzystuje od kilkudziesięciu do nawet kilkuset różnych czynników rankingowych związanych ze stronami internetowymi, aby oceniać, które z nich będą najbardziej trafne i przydatne dla użytkownika wyszukującego daną frazę. Oczywiście pełna lista elementów rankingowych i to, jaką mają wagę (znaczenie) poszczególne z nich, jest pilnie strzeżoną tajemnicą amerykańskiego giganta. Pamiętać trzeba również, że waga danego czynnika może zmieniać się diametralnie w zależności od charakteru zapytania. Przykładowo data utworzenia treści będzie dużo ważniejsza dla wyszukiwań związanych z aktualnymi wydarzeniami, niż dla definicji słownikowych.

Wszystkie informacje o stronach i materiałach dostępnych w internecie zbierane są do indeksu wyszukiwarki, a algorytmy Google zajmują się analizą zgromadzonych wskaźników i na ich podstawie ustalają ranking stron najlepiej odpowiadających na dane zapytanie. Dlaczego w tym celu potrzebnych jest wiele różnych algorytmów, a nie tylko jeden większy? Jedną z przyczyn jest nieustanne ewoluowanie świata internetu i konieczność dostosowania wyszukiwarki do zachodzących zmian. Innym powodem, prawdopodobnie nawet ważniejszym, jest dążenie Google do ulepszania jakości wyników wyszukiwania i chęć dostarczania rezultatów możliwie jak najlepiej odpowiadających intencjom użytkownika. Z tego względu Google na przestrzeni lat cały czas wprowadzał kolejne nowe algorytmy, które miały analizować i oceniać nowe czynniki rankingowe, a także lepiej odczytywać intencje wyszukującego i kontekst zapytania. Ponadto od samego początku działania wyszukiwarki do poszczególnych algorytmów wdrażane są poprawki nazywane też aktualizacjami lub z angielskiego update’ami algorytmów Google. Mają one za zadanie ulepszać działanie obecnych algorytmów, a tym samym zwiększać jakość wyników wyszukiwania i zadowolenie użytkowników. Mówiąc o udoskonalaniu algorytmów Google, warto również wspomnieć, że do tego celu wykorzystywana jest m.in. grupa tysięcy zewnętrznych testerów jakości analizujących wyniki wyszukiwania (tzw. Search Quality Team). Ponadto Google już kilka lat temu zaczął korzystać z technologii machine learning, czyli uczenia maszynowego, które pozwala jeszcze bardziej ulepszać wyszukiwarkę.

Algorytmy Google – które są najważniejsze?

Dostarczenie trafnych i przydatnych rezultatów wyszukiwania wymaga użycia wielu algorytmów badających bardzo różne czynniki, dlatego aby dobrze zrozumieć mechanizm wyszukiwarki, warto dowiedzieć się, jak działają i czego dotyczą najważniejsze algorytmy. Poznać należy również ich największe aktualizacje.

Pełna lista algorytmów wykorzystywanych przez Google nie jest niestety znana. Można założyć, że jest ich od kilkunastu do kilkudziesięciu. Ponadto tylko niektóre z nich zostały przez Google szczegółowo zaprezentowane i opisane. Niemniej na podstawie zarówno oficjalnych komunikatów od amerykańskiego koncernu, jak i wielu analiz i testów przeprowadzonych w branży SEO udało się zebrać całkiem dużo informacji na temat działania głównych algorytmów Google. Poniżej przedstawiamy listę najważniejszych algorytmów wprowadzanych na przestrzeni ostatnich lat, które mają największy wpływ na ranking stron, jak również zestawienie najistotniejszych aktualizacji, które wywołały największe przetasowania stron w wynikach Google.

PageRank

Algorytm „PageRank” wprowadzony został w samych początkach działania wyszukiwarki Google w 1998 roku i opracowany był przez jej współzałożycieli – Larry’ego Page’a i Siergieja Brina. Jako ciekawostkę można wspomnieć, że nazwa algorytmu wcale nie pochodzi od angielskiego słowa „page” oznaczającego stronę, ale właśnie od nazwiska jednego z twórców. Zadaniem algorytmu PageRank była ocena wartości strony na podstawie ilości i jakości linków prowadzących do niej z innych stron. Wysokość oceny wskaźnika PageRank określana była w skali od 0 do 10, dzięki czemu bardzo łatwo można było porównywać strony między sobą. Taka możliwość wynikała z publicznego udostępniania przez Google informacji o wartości PageRank danej strony w ramach paska narzędziowego Google ToolBar w przeglądarkach oraz w narzędziach dla webmasterów (Google Webmaster Tools – obecnie Google Search Console).

Algorytm PageRank był stosunkowo łatwy do zmanipulowania i zdając sobie sprawę z wykorzystywania tego faktu przez pozycjonerów, Google stopniowo ograniczał jego znaczenie i zastępował innymi algorytmami. Ostatnia oficjalna aktualizacja wartości PageRank miała miejsce w 2013 r., a w roku 2016 Google całkowicie zrezygnował z udostępniania na zewnątrz informacji o wskaźniku. Przekazano wtedy, że PageRank nadal ma być wykorzystywany przez algorytm wyszukiwarki, jednak czy jest tak do dziś, pozostaje w strefie domysłów i spekulacji.

Algorytm Panda

Dążenie do dostarczania jak najbardziej wartościowych stron w wynikach Google doprowadziło w 2011 r. do wdrożenia jednego z najbardziej przełomowych wówczas algorytmów, nazwanego „Panda”. Jego celem było obniżenie pozycji stron niskiej jakości, zawierających nieoryginalne treści, a także typowo spamowych. Algorytm Google Panda w znacznym stopniu ograniczył zjawisko celowego upychania fraz kluczowych na stronach (tzw. „keyword stuffing).

Początkowo Panda działała na zasadzie dodatkowego filtra i przez pierwsze 2 lata co miesiąc uruchamiane były jej aktualizacje, jednak w 2016 r. została włączona do głównego algorytmu wyszukiwania Google.

- Uruchomienie: 24 lutego 2011

- Cel: zwalczanie stron niskiej jakości, z mało wartościowymi, powielonymi i krótkimi treściami („thin content”)

Pingwin (Google Penguin)

Wprowadzenie przez Google w 2012 r. nowego algorytmu „Pingwin” doprowadziło do prawdziwego trzęsienia ziemi w wynikach wyszukiwania. W wyniku kar nałożonych przez algorytm bardzo wiele stron zanotowało olbrzymie spadki pozycji w Google, a część witryn zostało nawet całkowicie usuniętych z indeksu wyszukiwarki. Stało się tak, ponieważ zadaniem algorytmu Pingwin było zwalczanie witryn posiadających nienaturalny profil linków przychodzących i stosujących niedozwolone metody pozyskiwania backlinków, a było to wtedy zjawiskiem dość powszechnym.

Początkowo Pingwin działał podobnie jak Panda, choć odświeżany był znacznie rzadziej i ukarane witryny musiały często czekać wiele miesięcy do kolejnej aktualizacji, aby mogły powrócić na wcześniejsze pozycje. Wymagało to zwykle także pozbycia się problematycznych linków prowadzących do witryny. Zmieniło się to dopiero w roku 2016 wraz z wprowadzeniem aktualizacji Pingwin 4.0. W jej efekcie Pingwin został włączony do głównego algorytmu Google oraz co bardzo ważne, zamiast nakładać kary za spamowe linki, zaczął je ignorować.

- Uruchomienie: 24 kwietnia 2012

- Cel: karanie witryn pozyskujących linki masowo, ze spamowych witryn, fram linków, systemów wymiany linków, niepowiązanych tematycznie stron, z nienaturalnym profilem anchor textów.

Page Layout (Above the fold)

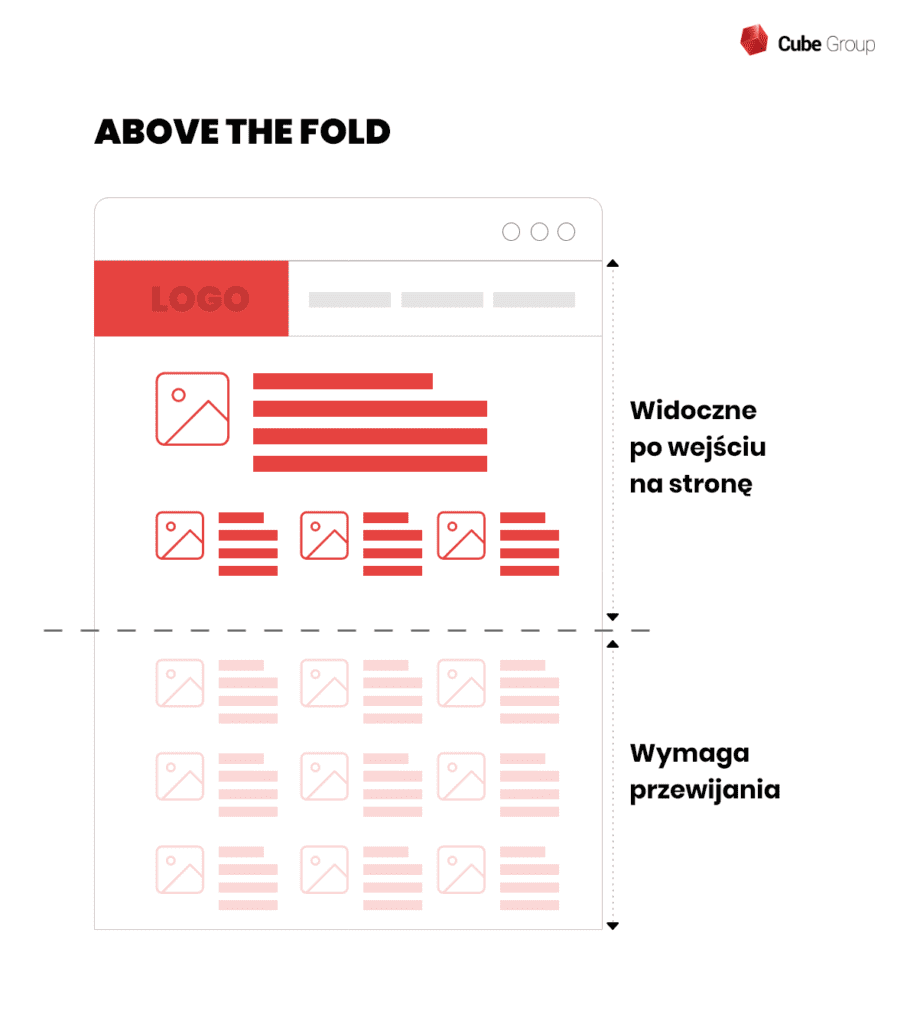

Jedną z istotnych zmian w wyszukiwarce Google w nieco wcześniejszych latach było także wdrożenie algorytmu, który kontrolował ilość reklam w górnej części strony widocznej bez przewijania, określanej z angielskiego jako „above the fold”. Aktualizacja algorytmu nazywanego również „Google Top Heavy” wymierzona była przeciwko stronom posiadającym nadmierną liczbę reklam w tej części lub gdy są one zbyt rozpraszające i utrudniają odnalezienie faktycznej treści.

- Uruchomienie: 19 stycznia 2012

- Cel: zwalczanie witryn stosujących reklamy natarczywe i zbyt liczne w górnej części strony

Koliber (Google Hummingbird)

Do najważniejszych algorytmów wprowadzonych przez Google w ostatnim czasie z całą pewnością zalicza się „Koliber”. Jest to zupełnie nowy silnik wyszukiwarki, dzięki któremu Google zaczął dużo lepiej rozumieć intencje użytkownika i odpowiednio interpretować zapytania. Dzięki Kolibrowi wyższe pozycje w wynikach Google zaczęły zyskiwać te strony, które tematyką i kontekstem faktycznie odpowiadają intencji wyszukiwania, a nie tylko są dopasowane do frazy kluczowej wpisanej w Google. Algorytm Hummingbird bada zależności między słowami występującymi w zapytaniu oraz ich prawdziwe znaczenie i w efekcie może wyświetlić strony, które wcale nie zawierają wyszukiwanej frazy, ale najlepiej odpowiadają na pytanie użytkownika.

Do najważniejszych algorytmów wprowadzonych przez Google w ostatnim czasie z całą pewnością zalicza się „Koliber”. Jest to zupełnie nowy silnik wyszukiwarki, dzięki któremu Google zaczął dużo lepiej rozumieć intencje użytkownika i odpowiednio interpretować zapytania. Dzięki Kolibrowi wyższe pozycje w wynikach Google zaczęły zyskiwać te strony, które tematyką i kontekstem faktycznie odpowiadają intencji wyszukiwania, a nie tylko są dopasowane do frazy kluczowej wpisanej w Google. Algorytm Hummingbird bada zależności między słowami występującymi w zapytaniu oraz ich prawdziwe znaczenie i w efekcie może wyświetlić strony, które wcale nie zawierają wyszukiwanej frazy, ale najlepiej odpowiadają na pytanie użytkownika.

- Uruchomienie: 22 sierpnia 2013

- Cel: lepsze rozumienie kontekstu wyszukiwania i interpretowanie zapytań, zwłaszcza bardziej rozbudowanych tzw. „long tail keywords” oraz dopasowanie wyników do intencji użytkownika

Google RankBrain

Przedstawiony w 2016 r. algorytm RankBrain jest pierwszym, który według oficjalnych informacji Google zaczął korzystać z technologii uczenia maszynowego (ang. machine learning). RankBrain odpowiada m.in. za nowy sposób interpretowania zapytań, jednak nie zastąpił on głównego algorytmu wyszukiwania – Kolibra, lecz został do niego włączony. Według jednego z inżynierów Google algorytm RankBrain stał się trzecim najważniejszym czynnikiem wpływającym na ranking wyszukiwarki.

Dzięki wykorzystaniu „sztucznej inteligencji” RankBrain jest szczególnie przydatny do obsługi zupełnie nowych zapytań, które nigdy wcześniej nie były wyszukiwane. Potrafi on lepiej zrozumieć jakie inne słowa lub frazy mają podobne znaczenie do tych szukanych przez użytkownika i jak inaczej można sformułować dane zapytanie.

Pewien czas po uruchomieniu RankBrain’a pojawiły się analizy wskazujące, że wpłynął on na poprawę wyników witryn, które oprócz jakościowego contentu dbają także o doświadczenia użytkowników (UX). Z kolei negatywny efekt wywarł według analiz na strony z dużym współczynnikiem odrzuceń.

- Uruchomienie: dokładna data nieznana, ujawniony 26 października 2016

- Cel: badanie powiązań między słowami, trafniejsze interpretowanie zapytań i rozumienie intencji

Google BERT

Wdrożony w 2019 r. algorytm był jedną z największych zmian w mechanizmie wyszukiwarki na przestrzeni kilku lat. Nazwa BERT to skrót od angielskiego „Bidirectional Encoder Representation from Transformers”. Za tą dość skomplikowaną nazwą kryje się m.in. włącznie do algorytmu technologii przetwarzania naturalnego języka (Natural Language Processing – NLP). Dzięki temu BERT potrafi lepiej interpretować treści, a w efekcie dostarczać trafniejsze wyniki wyszukiwania zwłaszcza dla długich i skomplikowanych zapytań typu long-tail. Jest to szczególnie ważne wobec coraz szybszego rozwoju wyszukiwań głosowych, gdzie użytkownicy stosują właśnie bardziej naturalne sformułowania zbliżone do codziennego języka komunikacji, zamiast typowych fraz kluczowych wpisywanych na urządzeniach.

- Uruchomienie: październik 2019 (język angielski), grudzień 2019 (kolejne 70 języków w tym polski).

- Cel: lepsze zrozumienie naturalnego języka i interpretowanie zapytań

Aktualizacje algorytmu Google

Jak wspomniano wcześniej, oprócz tworzenia zupełnie nowych algorytmów nieustannie wprowadzane są także poprawki do już istniejących algorytmów. Według oficjalnych informacji przedstawionych przez Google wdrażanych jest kilka aktualizacji dziennie. Daje to liczbę kilku tysięcy update’ów algorytmu Google w ciągu roku (w 2020 r. było ich ok. 4 500). Na szczęście zdecydowana większość z nich to tylko niewielkie poprawki, które nie powodują dużych zmian w wynikach wyszukiwania. Mniej więcej kilkanaście razy w roku wprowadzane są jednak duże aktualizacje algorytmu Google, w efekcie których dochodzi do bardzo wyraźnych zmian pozycji w Google dla znacznej liczby witryn.

W początkowym okresie działania amerykańskiej wyszukiwarki, a nawet jeszcze kilka lat temu, nie były podawane przez Google niemal żadne oficjalne informacje o dużych update’ach. Komunikaty pojawiały się jedynie w przypadku wdrożenia istotnego nowego algorytmu lub uruchomienia aktualizacji bardzo ważnej dla właścicieli stron ze względu na nałożone kary jak w przypadku algorytmu Pingwin czy Panda. Na szczęście w ostatnich latach podejście koncernu zmieniło się na bardziej transparentne i przynajmniej kilka razy w roku Google informuje o większych aktualizacjach, w tym także o zmianach głównego rdzenia algorytmu, czyli tzw. „Core update”.

Dla dobrego zrozumienia aktualnych zasad, według których Google ocenia strony i ustala ich kolejność, warto zapoznać się z najważniejszymi aktualizacjami algorytmu z ostatnich lat przedstawionymi poniżej.

Mobile friendly update (Mobilegeddon)

- Data: 21 kwietnia 2015

Odpowiadając na trend zwiększającej się liczby odwiedzin witryn z urządzeń mobilnych, Google dodał do algorytmu nowe czynniki oceniające, w jakim stopniu strony są przystosowane do urządzeń przenośnych. Wraz z uruchomieniem aktualizacji Google udostępnił nowe darmowe narzędzie online pozwalające przetestować poziom dostosowania strony do wyświetlania na telefonach i tabletach tzw. „Mobile friendly test”. Co zdarza się bardzo rzadko, Google ogłosił wprowadzenie tego update’u z wyprzedzeniem i powszechnie oczekiwano, że przyniesienie on olbrzymie przetasowania w wynikach wyszukiwania. Z tego względu nadana została mu nieoficjalna nazwa „Mobilegeddon”. W rzeczywistości nie doszło wtedy do żadnych dramatycznych wydarzeń, jednak już rok później – 12 maja 2016 r. wdrożony został drugi Mobile friendly update, który sprawił, że czynniki rankingowe dotyczące wersji mobilnej strony zaczęły mocniej wpływać na jej pozycje w Google.

Mobile first indexing

- Data: 26 marca 2018

Kontynuacją zmian zapoczątkowanych przez aktualizacje Mobile friendly było wprowadzenie w 2018 roku nowego sposobu indeksowania stron przez Google tzw. „Mobile first indexing”. Od tego momentu w celu ustalenia pozycji strony w Google, zrozumienia jej zawartości i wyświetlenia opisu na liście wyników, algorytm w pierwszej kolejności zaczął korzystać z mobilnej wersji strony. Bardzo ważne stało się więc posiadanie sprawnie działającej i przyjaznej użytkownikom strony mobilnej, która zawiera pełnowartościowe treści, nieokrojone w stosunku do wersji na komputery.

Medic update (YMYL / EAT update)

- Data: 1 sierpnia 2018

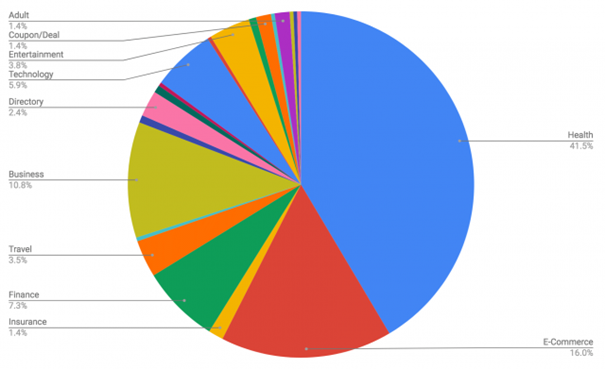

Jedną z największych i najważniejszych aktualizacji algorytmu Google w ostatnich latach był tzw. „Medic update”, którego nazwa wynika z bardzo dużego wpływu jaki miał m.in. na witryny związane ze zdrowiem i medycyną. Zasięg tej aktualizacji był w rzeczywistości jednak znacznie szerszy i bardzo duże skoki pozycji w wynikach wyszukiwania zanotowały wtedy strony z obszernej grupy określonej przez Google jako YMYL. Jest to skrót od angielskiego „Your Money Your Life” odnoszący się do witryn, których funkcjonowanie może mieć wpływ na szeroko pojęte zdrowie i finanse użytkowników. Zaliczają się tutaj strony zawierające artykuły i porady zdrowotne, finansowe, zakupowe, a także gromadzące dane osobiste i przeprowadzające transakcje finansowe. Potwierdzeniem takiego ukierunkowania Medic update’u, są poniższe wyniki ankiety przeprowadzonej na branżowym portalu wśród przedstawicieli witryn dotkniętych aktualizacją.

Ponieważ zdrowie oraz finanse są niezwykle ważnymi dziedzinami życia Google uznał, że strony internetowe związane z tymi obszarami wymagają bardzo dokładnej i rygorystycznej oceny pod kątem czynników określanych jako E-A-T (ang. „Expertise, Authoritativeness, Trustworthiness”). Dzięki zwiększeniu ich znaczenia w algorytmie, dla zapytań z tak wrażliwego zakresu, wyświetlane są przede wszystkim strony prezentujące treści eksperckie, posiadające wysoki autorytet oraz cieszące się dużym zaufaniem i wiarygodnością.

Page experience update (Core Web Vitals)

- Data: 15 czerwca 2021

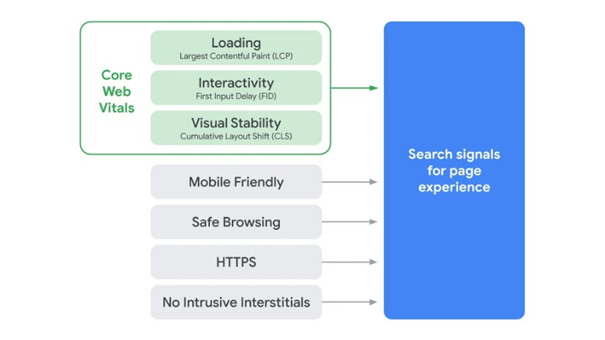

Inną niezwykle istotną aktualizacją algorytmu Google w ostatnim czasie było dodanie nowej grupy czynników rankingowych oceniających elementy strony wpływające na wrażenia użytkownika (user experience – UX). Sygnały te nazwane przez Google „Core Web Vitals” wraz z innymi starszymi czynnikami utworzyły nową grupę – Page Experience Signals.

Od momentu wdrożenia Page experience update w 2021 r. algorytm Google ustalając pozycje strony w wyszukiwarce, ocenia także jej 3 wskaźniki Core Web Vitals:

- LCP – Largest Contentful Paint

- FID – First Input Delay

- CLS – Cumulative Layout Shift

| Jeśli chcesz poznać szczegóły nowych wskaźników i dowiedzieć się jak dostosować swoją stronę do wymogów Google w tym zakresie pobierz nasz specjalny poradnik Core Web Vitals. |

Core updates (Google broad core algorithm updates)

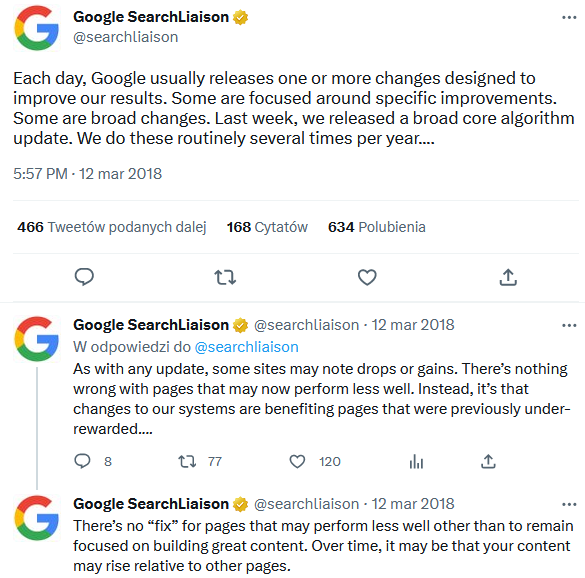

- Data pierwszego komunikatu z wyjaśnieniem: 12 marca 2018

Spośród tysięcy aktualizacji algorytmu Google wprowadzanych każdego roku tylko w pojedynczych przypadkach koncern oficjalnie informuje, czego dokładnie dotyczą zmiany i kiedy wskazany update został uruchomiony. Od samego początku działania wyszukiwarki regularnie wprowadzane są poprawki do rdzenia głównego algorytmu, których efektem są duże zmiany pozycji wielu różnych stron, jednak zwłaszcza we wcześniejszych latach były one bardzo rzadko potwierdzane przez Google. Podejście koncernu zmieniło się mniej więcej od 2018 roku, gdy po raz pierwszy wydany został oficjalny komunikat nie tylko potwierdzający update, ale i ogólnikowo przedstawiający czym charakteryzują się aktualizacje nazwane „broad core algorithm upadate”. Szczegóły poniżej:

Od tego czasu Google zaczął znacznie częściej informować o szerokich zmianach w głównym algorytmie i nadawać im nawet własne nazwy jak np. March 2019 Core Update. Ponadto regularnie zaczęły pojawiać się komunikaty o bardziej szczegółowych aktualizacjach takich jak „product reviews update”, „spam udate”, czy „helpful content update”. Pełna lista takich aktualizacji od 2020 r. dostępna jest na stronie: https://developers.google.com/search/updates/ranking

Podsumowanie

Wprowadzanie nowych algorytmów i tysiące mniejszych lub większych zmian i poprawek w algorytmach to rzeczywistość, która towarzyszy wyszukiwarce Google od samego początku działania. Aby być przygotowanym na kolejne aktualizacje i zminimalizować ryzyko, że spowodują one duże spadki pozycji strony w Google i zmniejszenie ruchu, konieczna jest nie tylko dobra znajomość wytycznych i wymogów Google. Ważne jest także bieżące śledzenie i analizowanie zmian w algorytmach i umiejętne prowadzenie działań SEO przez doświadczonych specjalistów.